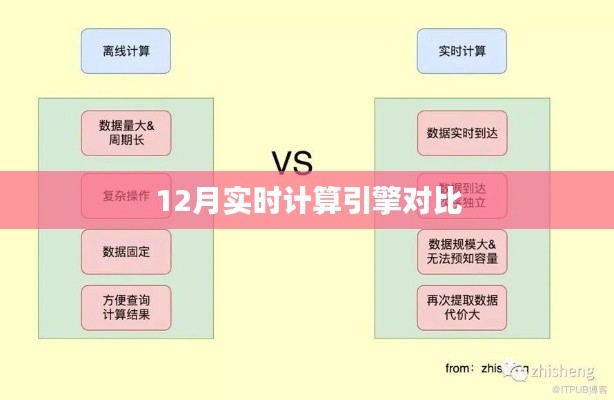

随着大数据时代的到来,实时计算引擎作为数据处理的关键技术,受到了广泛关注,本文将选取市场上几款主流的实时计算引擎进行对比分析,帮助读者更好地了解它们的特点和优劣。

概述

实时计算引擎是指能够在数据产生后立即进行处理的计算系统,其目标是在短时间内对海量数据进行快速分析并产生结果,在大数据处理、机器学习、物联网等领域有着广泛的应用,目前市场上主流的实时计算引擎包括Apache Flink、Apache Beam、Spark Streaming等。

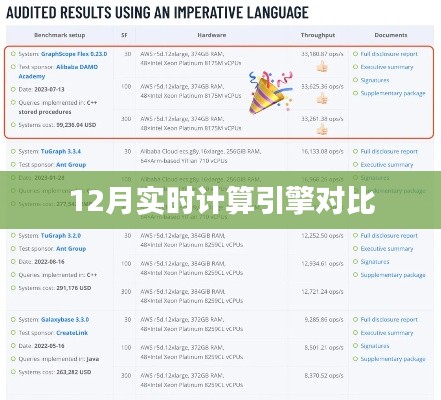

实时计算引擎对比分析

1、Apache Flink

Apache Flink是一个开源的流处理框架,以其高吞吐量和低延迟的特性著称,Flink支持处理有界和无界数据流,并提供了丰富的API和工具集,它支持多种编程语言,包括Java、Scala和Python等,Flink还提供了强大的状态管理和容错机制,保证了系统的稳定性和可靠性。

优势:

(1)高吞吐量和低延迟:Flink能够处理大规模数据,同时保证低延迟的处理速度。

(2)强大的状态管理能力:支持复杂的事件驱动处理,适用于需要维护状态的应用场景。

(3)良好的扩展性:Flink的分布式架构可以很好地扩展到大规模集群。

劣势:

(1)学习曲线较陡峭:对于初学者来说,Flink的API和概念可能需要一段时间来熟悉。

(2)资源需求较高:在处理大规模数据时,Flink需要较多的计算资源。

2、Apache Beam

Apache Beam是一个用于处理批量数据和流式数据的开源框架,由Google开发并贡献给Apache基金会,Beam提供了一种声明式编程模型,使得数据处理变得更加简单和可维护。

优势:

(1)声明式编程模型:通过抽象化的编程模型,降低了数据处理的复杂性。

(2)跨平台支持:Beam支持多种运行环境,包括Google Cloud Dataflow、Apache Flink等。

(3)强大的扩展性:Beam可以很好地扩展到大规模集群,处理海量数据。

劣势:

(1)相对较为年轻:Beam相较于其他实时计算引擎,其生态系统还在不断发展中。

(2)资源需求较高:在处理大规模数据时,Beam也需要较多的计算资源。

3、Spark Streaming

Spark Streaming是Apache Spark的一个扩展库,专门用于处理流式数据,它提供了高吞吐量的数据处理能力,并且可以与Spark的其他组件无缝集成。

优势:

(1)与Spark集成:Spark Streaming可以与Spark的其他组件(如MLlib、GraphX等)无缝集成,方便进行数据处理和分析。

(2)高可靠性:Spark Streaming提供了高容错性的数据处理能力,保证了数据的可靠性。

(3)易用性:相对于其他实时计算引擎,Spark Streaming的API更加简单易用。

劣势:

(1)延迟较高:相较于Flink等实时计算引擎,Spark Streaming的处理延迟较高。

(2)资源占用较多:在处理大规模数据时,Spark集群需要占用较多的计算资源。

Apache Flink、Apache Beam和Spark Streaming都是优秀的实时计算引擎,各有其特点和优势,在选择实时计算引擎时,需要根据具体的应用场景和需求进行考虑,对于需要高吞吐量和低延迟的场景,Flink是一个不错的选择;对于需要声明式编程模型和跨平台支持的场景,可以考虑使用Beam;而对于需要与Spark其他组件集成的场景,Spark Streaming可能更加合适。

转载请注明来自新时代明师,本文标题:《实时计算引擎对比报告,深度解析12月性能差异》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...